Introducción

Blip2 es una inteligencia artificial que es capaz de tomar una imagen o vídeo como entrada y tener una conversación y responder preguntas o entregar contexto de lo que muestra esta entrada de manera muy certera 🤯

Instalación

Para poder instalar esta herramienta lo mejor es crearse un nuevo entorno de Anaconda

!$ conda create -n blip2 python=3.9Copied

Ahora nos metemos en el entorno

!$ conda activate blip2Copied

Instalamos todos los módulos necesarios

!$ conda install pytorch torchvision torchaudio pytorch-cuda=11.7 -c pytorch -c nvidiaCopied

!$ conda install -c anaconda pillowCopied

!$ conda install -y -c anaconda requestsCopied

!$ conda install -y -c anaconda jupyterCopied

Por último instalamos Blip2

!$ pip install salesforce-lavisCopied

Uso

Cargamos las librerías necesarias

import torchfrom PIL import Imageimport requestsfrom lavis.models import load_model_and_preprocessCopied

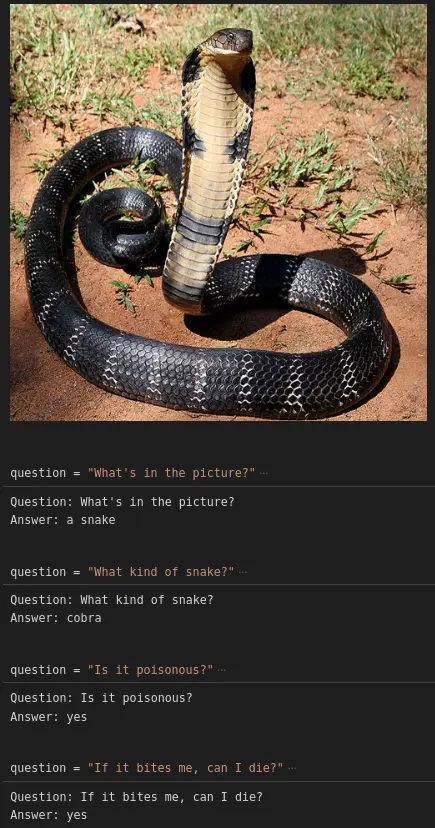

Cargamos una imagen de ejemplo

img_url = 'https://upload.wikimedia.org/wikipedia/commons/thumb/4/4d/12_-_The_Mystical_King_Cobra_and_Coffee_Forests.jpg/800px-12_-_The_Mystical_King_Cobra_and_Coffee_Forests.jpg'raw_image = Image.open(requests.get(img_url, stream=True).raw).convert('RGB')display(raw_image.resize((500, 500)))Copied

<PIL.Image.Image image mode=RGB size=500x500>

Establecemos la GPU si la hay

device = torch.device("cuda" if torch.cuda.is_available() else 'cpu')deviceCopied

device(type='cuda')

Asignamos un modelo. En mi caso que tengo un ordenador con 32 GB de RAM y una GPU 3060 con 12 GB de VRAM no puedo usar todos, por lo que he puesto al lado un comentario ok con los modelos que he podido usar, y los que no, el error que me ha dado. Si tienes un ordenador con igual RAM y VRAM ya sabes cuáles puedes usar, si no, tienes que probar

# name = "blip2_opt"; model_type = "pretrain_opt2.7b" # ok# name = "blip2_opt"; model_type = "caption_coco_opt2.7b" # FAIL VRAM# name = "blip2_opt"; model_type = "pretrain_opt6.7b" # FAIL RAM# name = "blip2_opt"; model_type = "caption_coco_opt6.7b" # FAIL RAM# name = "blip2"; model_type = "pretrain" # FAIL type error# name = "blip2"; model_type = "coco" # okname = "blip2_t5"; model_type = "pretrain_flant5xl" # ok# name = "blip2_t5"; model_type = "caption_coco_flant5xl" # FAIL VRAM# name = "blip2_t5"; model_type = "pretrain_flant5xxl" # FAILmodel, vis_processors, _ = load_model_and_preprocess(name=name, model_type=model_type, is_eval=True, device=device)vis_processors.keys()Copied

Loading checkpoint shards: 0%| | 0/2 [00:00<?, ?it/s]

dict_keys(['train', 'eval'])

Preparamos la imagen para meterla al modelo

image = vis_processors["eval"](raw_image).unsqueeze(0).to(device)Copied

Analizamos la imagen sin preguntar nada

model.generate({"image": image})Copied

['a black and white snake']

Analizamos la imagen preguntando

prompt = NoneCopied

def prepare_prompt(prompt, question):if prompt is None:prompt = question + " Answer:"else:prompt = prompt + " " + question + " Answer:"return promptCopied

def get_answer(prompt, question, model):prompt = prepare_prompt(prompt, question)answer = model.generate({"image": image,"prompt": prompt})answer = answer[0]prompt = prompt + " " + answer + "."return prompt, answerCopied

question = "What's in the picture?"prompt, answer = get_answer(prompt, question, model)print(f"Question: {question}")print(f"Answer: {answer}")Copied

Question: What's in the picture?Answer: a snake

question = "What kind of snake?"prompt, answer = get_answer(prompt, question, model)print(f"Question: {question}")print(f"Answer: {answer}")Copied

Question: What kind of snake?Answer: cobra

question = "Is it poisonous?"prompt, answer = get_answer(prompt, question, model)print(f"Question: {question}")print(f"Answer: {answer}")Copied

Question: Is it poisonous?Answer: yes

question = "If it bites me, can I die?"prompt, answer = get_answer(prompt, question, model)print(f"Question: {question}")print(f"Answer: {answer}")Copied

Question: If it bites me, can I die?Answer: yes